Meta가 Llama 3.1을 공개했습니다. Llama 3.1은 전례 없는 성능과 유연성을 자랑하며, 오픈 소스 AI 모델의 한계를 뛰어넘는 새로운 기준을 세웠습니다. 여기서는 이번 릴리스의 주요 내용을 소개합니다.

핵심 요약

-

오픈 소스 AI의 중요성: Meta의 Mark Zuckerberg는 오픈 소스가 개발자, Meta, 그리고 전 세계에 미치는 긍정적 영향을 강조하며, 누구나 접근 가능한 AI 개발의 중요성을 설명합니다.

-

주요 특징:

- Llama 3.1 405B: 세계 최대 규모의 오픈 소스 AI 모델로, 무려 4050억 개의 매개변수를 가지고 있습니다.

- 128K 컨텍스트 길이: 더 길고 복잡한 문맥을 이해할 수 있도록 컨텍스트 길이를 대폭 확장했습니다.

- 8개 언어 지원: 다국어 지원을 통해 글로벌 사용자를 위한 활용도를 높였습니다.

- Llama Guard 3 및 Prompt Guard: 강화된 보안 및 안전 도구로 책임 있는 AI 개발을 지원합니다.

-

광범위한 파트너십: AWS, NVIDIA, Databricks, Dell, Google Cloud 등을 포함한 25개 이상의 파트너와 협력하여 생태계를 확장합니다.

Llama 3.1의 혁신

성능 및 기능:

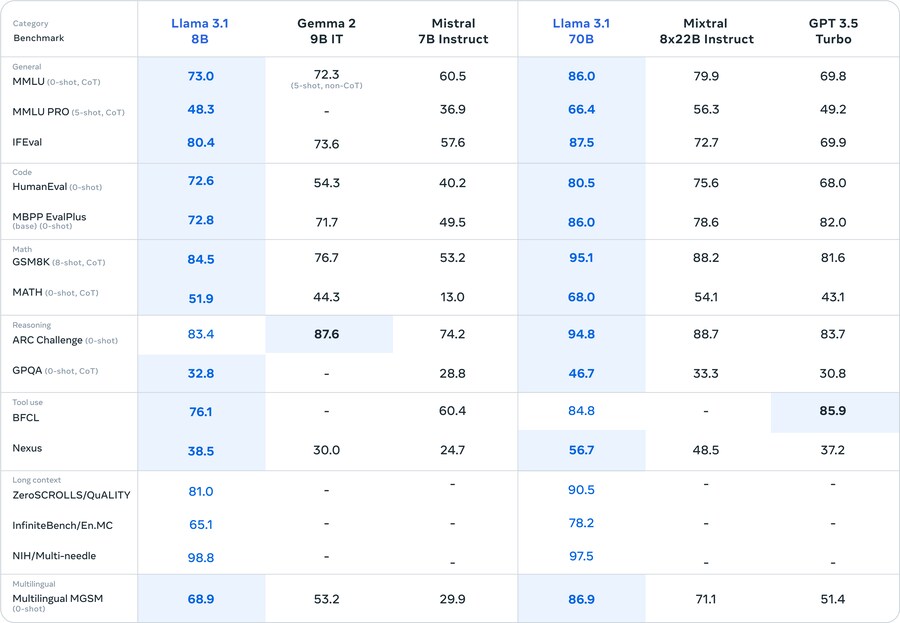

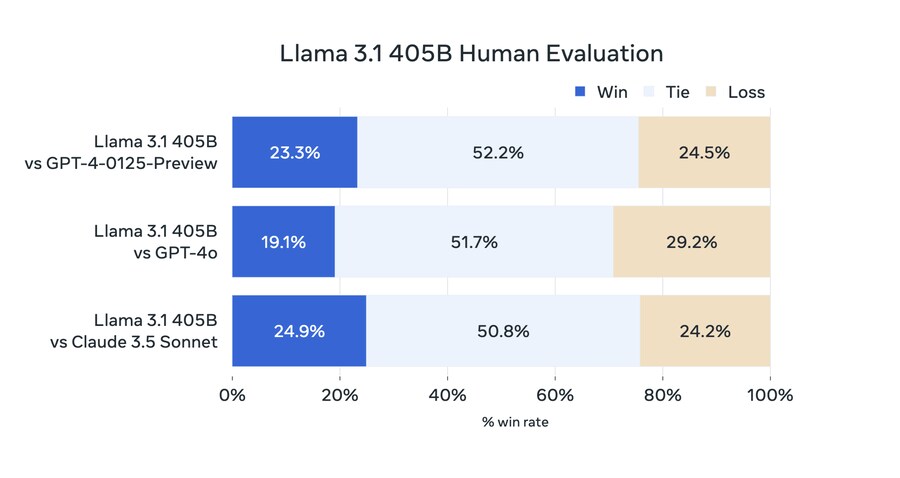

- 405B 모델: GPT-4 및 Claude 3.5 Sonnet과 경쟁할 수 있는 능력을 갖추고 있으며, 광범위한 도구 사용과 다국어 번역 능력을 보유하고 있습니다.

- 업그레이드된 8B 및 70B 모델: 더 긴 컨텍스트와 향상된 추론 능력을 통해 긴 텍스트 요약, 다국어 대화형 에이전트, 코딩 도우미 등 다양한 고급 사용 사례를 지원합니다.

모델 아키텍처:

- 대규모 훈련: 16,000개의 H100 GPU를 사용하여 15조 개 이상의 토큰으로 훈련했습니다.

- 양자화 기술: 16비트에서 8비트로 모델을 양자화하여 컴퓨팅 요구 사항을 줄이고 단일 서버 노드에서 실행할 수 있도록 했습니다.

안전성과 책임성:

- Llama Guard 3 및 Prompt Guard: 다국어 안전 모델과 프롬프트 주입 필터를 포함한 새로운 구성 요소를 통해 AI의 안전한 사용을 보장합니다.

- 커뮤니티 피드백: GitHub에서 Llama Stack에 대한 의견을 수렴하여 더 나은 인터페이스를 구축하고 있습니다.

커뮤니티와의 협력

Meta는 Llama 3.1을 통해 개발자들이 새로운 워크플로우를 열 수 있도록 지원합니다. 예를 들어:

- 합성 데이터 생성: 작은 모델의 훈련을 개선하기 위한 합성 데이터 생성.

- 모델 증류: 대규모 모델의 성능을 작은 모델로 전달하는 기술.

Llama 3.1은 다양한 파트너들과의 협력을 통해, 개발자들이 즉시 활용할 수 있는 도구와 지원을 제공합니다. AWS, NVIDIA, Dell 등의 파트너는 클라우드 및 온프레미스 환경에서 저지연 추론을 최적화했습니다.

마무리

Llama 3.1의 출시로 Meta는 오픈 소스 AI의 새로운 시대를 열고 있습니다. 이 강력한 모델을 통해 개발자들은 혁신적인 애플리케이션과 솔루션을 개발할 수 있으며, 더 나은 성능과 유연성을 경험할 수 있습니다. Meta는 커뮤니티와 함께 Llama 3.1을 책임감 있게 발전시키고, AI 기술을 전 세계에 더 널리 보급할 수 있기를 기대합니다.

Llama 3.1에 대한 자세한 내용은 ai.meta.com에서 확인해 보세요.

(여기까지는 gpt-4o로 작성되었습니다.)

제가 제일 중요하게 보는 코딩과 추론 능력에서는 여전히 3.5 sonnet이 1등이지만, 유저평가에서는 llama 3.1이 sonnet을 이겼다는 점도 흥미롭습니다. gpt-4o는 여기서도 여전히 유저평가에 강한 모습을 보여주고 있구요.. 만약 llama 3.1 405b를 직접 써보고 싶은 일반 유저분들은 https://www.perplexity.ai (구독 필요) 아니면 https://abacus.ai/ (구독 필요) 아니면 https://huggingface.co/chat/models/meta-llama/Meta-Llama-3.1-405B-Instruct-FP8 에서 영어로 써보실 수 있습니다.(llama 3.1에서 한국어는 지원되지 않습니다.) 96gb나 128gb 통합메모리의 맥북을 가지고 계신 분들은 70b모델을 로컬로 구동하실수 있으니 전문지식이 있다면 해보시는것도 괜찮을 것 같네요.